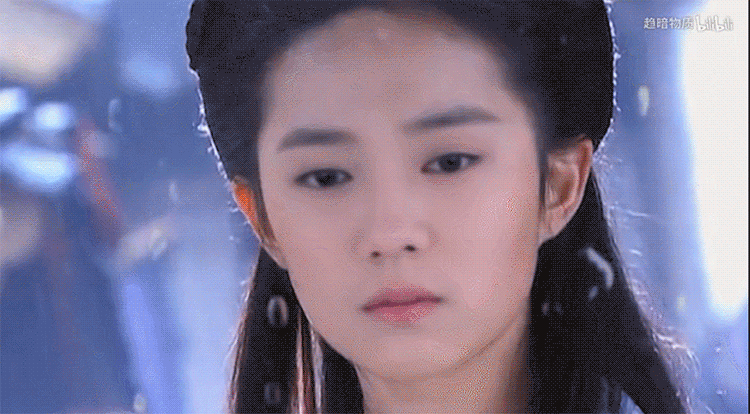

对于最近火爆的AI技术,大多数网友应该不会陌生,只需要提供一张带脸的照片,就可以把自己置换成视频、电视剧中的男(女)主角,而且拟真度非常高,毫无违和感。有人把鹿晗的脸置换到刘亦菲扮演的“小龙女”角色中,就是下面这个效果。如果不是事先看过《神雕侠侣》,还以为就是本人呢。

AI合成人脸,合成声音,这些技术的发展也被骗子运用到诈骗犯罪中,提醒各位市民要提高警惕,加强识别。

举个“栗子”

5月29日,咸安辖区一高校在校学生王某某在QQ上收到同学何某丽的消息,“何某丽”称她的朋友骑车摔了,在医院急用钱,但是其微信被冻结了,转不了钱,于是“何某丽”便把4000元钱转账到了王某某的建设银行卡中,并将转账截图发给了王某某,请王某某用微信把钱转给“何某丽”朋友的银行卡,王某某看到转账还没有到账心有疑虑,于是“何某丽”告诉王某某,不同的银行到账时间不同,让王某某等几个小时就应该到了。王某某半信半疑,担心被骗,要求确认身份,“何某丽”欣然同意,于是给王某某打了QQ视频电话,打通后,王某某看到了“何某丽”端正坐在宿舍桌子前, “何某丽”告诉王某某,她的室友已经睡了,让王某某别讲话,王某某在确认身份后就按照“何某丽”的要求,下载云闪付向“何某丽”提供的银行卡转账4000元钱。第二天凌晨,王某某发现“何某丽”向其转账的钱一直没有到账,于是在QQ上追问,但是同学一直没有回消息,直到上午10时许,QQ才回消息,何某丽回复其QQ被盗,双方电话沟通后,王某某才发现其被诈骗。

这就是通过AI换脸技术实施的诈骗

很容易让受骗人信以为真

需要提高警惕!

让我们一起来了解一下AI诈骗的常用手法!

第一种: 声音合成

骗子通过骚扰电话录音等来提取某人声音,获取素材后进行声音合成,从而可以用伪造的声音骗过对方。

案例:某公司财务小王接到领导电话,要求立刻给供应商转款2万元,并将转账信息以邮件形式发送,转款理由是避免缴纳滞纳金。由于老板的口音十分逼真,小王信以为真,在1小时内转款完成,后发现被骗。

第二种:AI换脸

人脸效果更易取得对方信任,骗子用AI技术换脸,可以伪装成任何人,再通过视频方式进行信息确认,真是防不胜防!

骗子首先分析公众发布在网上的各类信息,根据所要实施的骗术,通过AI技术筛选目标人群。在视频通话中利用AI换脸,骗取信任。

案例:近日,小李的大学同学通过QQ跟她借钱。对方打过来一段四五秒的视频电话,小李看到确实是本人,便放心转账3000元。然而,她在第二次转账时感觉异常,便再次拨通对方电话,这才得知同学的账号被盗,遂报案。警方判断,那段视频很有可能是被人换了脸。

第三种:转发微信语音

微信语音居然也能转发,这操作简直了!骗子在盗取微信号后,便向其好友“借钱”,为取得对方的信任,他们会转发之前的语音,进而骗取钱款。

尽管微信没有语音转发功能,但他们通过提取语音文件或安装非官方版本(插件),实现语音转发。

第四种:通过AI技术筛选受骗人群

骗子不是漫无目的地全面撒网,而是别有用心地锁定特定对象。他们会根据所要实施的骗术对人群进行筛选,从而选出目标对象。

举个栗子:当进行金融诈骗时,经常搜集投资信息的小伙伴会成为他们潜在的目标。

运用AI技术

再加上套路和剧本的演绎

这样的诈骗手段

小伙伴们能hold住吗?

还是那句话:

你目前还没被骗

并不是因为你多聪明

也不是因为你没钱

而是适合你的“剧本”还在路上